方法如下:

先说下背景,最近有个场景就是需要分析600多万行股票数据,这部分数据分2000多个csv存储在本地。我是使用powerbi desktop进行分析,所以每次需要加载更新,这时问题就来了,2000多个每次加载时间很久,因此我想把这部分数据导入sqlserver(原本想导入mysql or access,access存储不能超2G忽略,mysql在powerbi不支持增量刷新抛弃),试过了很多办法都不太理想。最后找个一个很给力的解决方案

1、powerbi desktop 里的powerquery加载数据,进行合并;

2、合并后的数据加载至powerbidesktop;

3、打开powerbi desktop 上安装的dax studio插件;

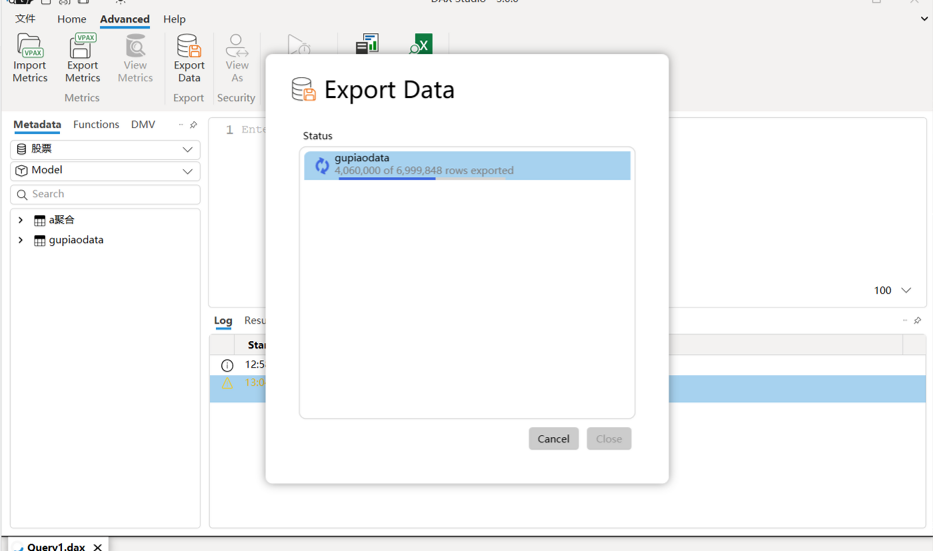

4、在studio界面选择advance,然后是export data,选择导出到sql

5、下一步如果你的sqlserver是云就输入云地址,如果是本地就选择本地计算机名称和数据库名称,之后点击导入即可

6、接下来他就会自动将数据写入数据库了,亲测这个最简单而且不容易出错。

附导入过程截图:

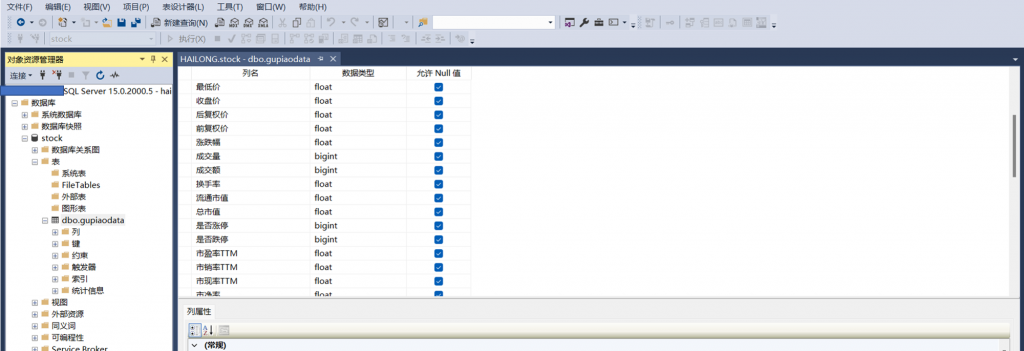

导入成功后回到sqlserver studio就可以看到导入的数据库

至此,大功告成~

一步数据

一步数据